Datařina nuda je, má však cenné údaje: Průvodce datovou analytikou

Mám chuť se rozepsat, co znamenají různé pojmy z oblasti datové analytiky. Měl jsem nedávno skvělou přednášku od odborníka z praxe, který dokázal vysvětlit datové pojmy jednoduše. Datový sklad, data pipeline, data science, AI, ML a další pojmy. Mluví se o nich čím dál častěji a mým cílem je se do nich ponořit.

Proč o tom píšu? Buďme upřímní, kdo se v tom má vyznat. Ne každý s tím přišel do styku. Z tohoto článku bych bych chtěl na příkladech z praxe popsat, jak tečou data a přes jaké bariéry se musí přebrodit ke koncovému uživateli. Zároveň se budu snažit ke každému pojmu vložit konkrétní nástroje, kde si budete moct na vlastní kůži datařinu vyzkoušet.

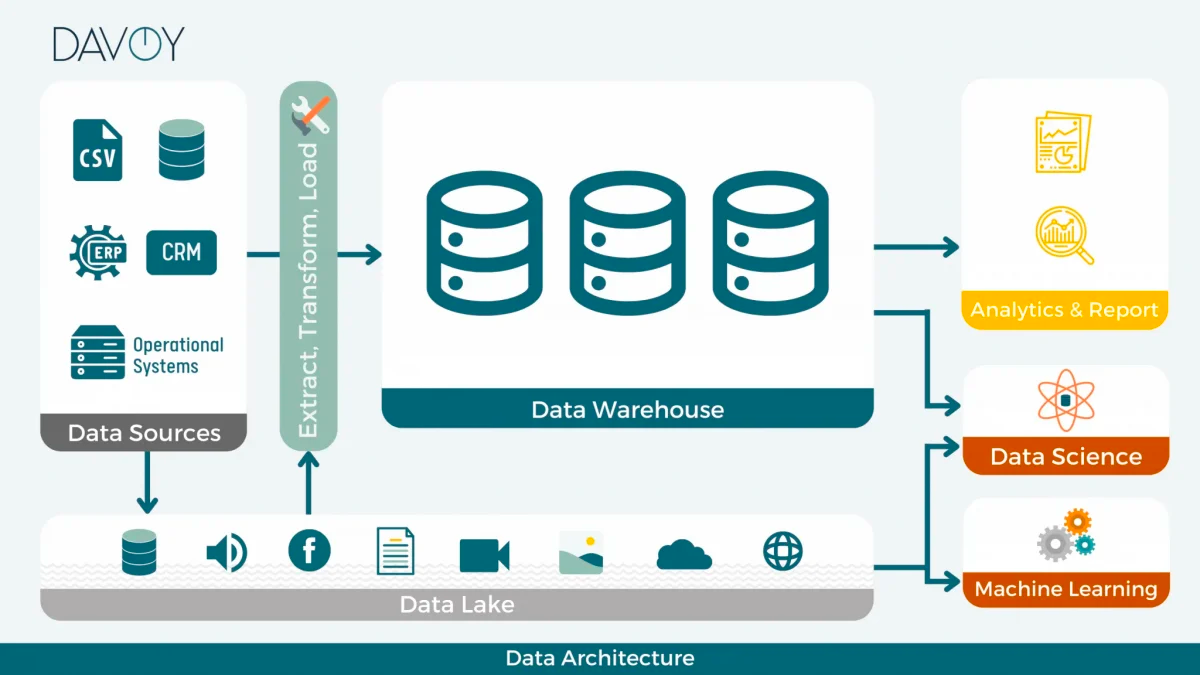

1) Datový sklad

Asi si umíme představit, že je to místo, kde se data ukládají. Ale odkuď se data berou a co probíhá na pozadí? Nedávno jsem slyšel krásné přirovnání, kdy datový sklad se dá připodobnit k ledničce. Do ledničky dáváme různé potraviny (neboli datové zdroje), například zeleninu, mléčné výrobky nebo maso. Když dostaneme hlad, šáhneme do ledničky pro jídlo a zkonzumujeme ji (reporty). Když nám ale stále chrčí v břiše, veme si další jídlo a sledujeme, jestli se stav zlepšil:).

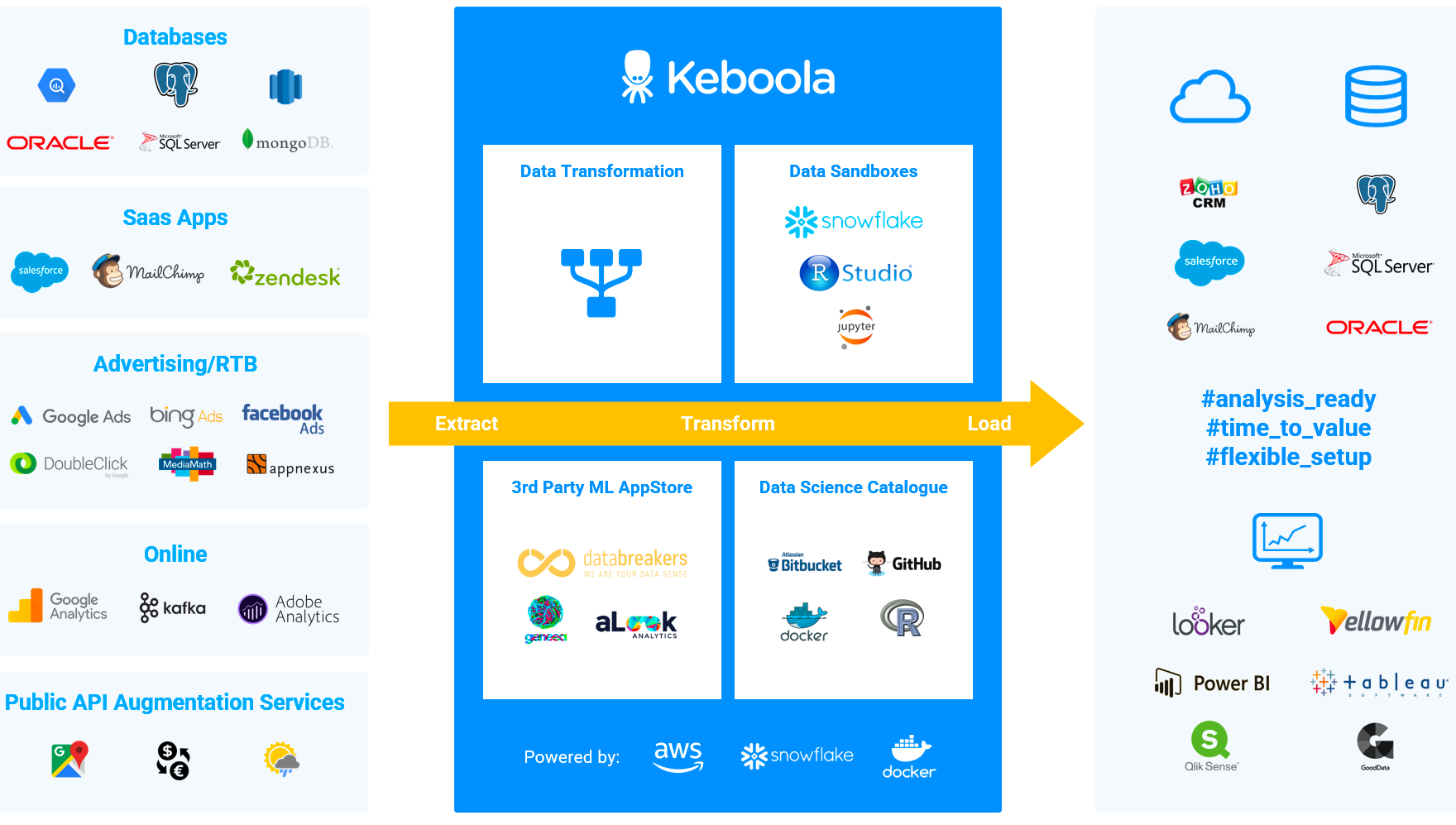

S boomem cloudových služeb se pro datové sklady používají platformy jako je AWS, Azure nebo Google Cloud. Mezi dataři je nejvíce oblíbený Snowflake, který nabízí integraci do ETL platforem, jako je česká Keboola nebo Dataddo. Nedávno Keboola nabrala rekordní investici ve výši 32 milionů dolarů. Jestli můžeme být v Česku na něco hrdí, tak to jsou zajímavé datové firmy s globální působností.

2) ETL procesy, data pipelines, datové zdroje

Vrátíme se zpátky k přirovnání. Abychom do ledničky dostali potraviny, potřebujeme pro ně dojít do obchodu nebo je nám doveze kurýr domů. Stejným způsobem fungují ETL (Extract Transform Load), které dopraví do datového skladu datový zdroj. Jelikož máme různé specializované obchody, pro něco si dojdu do masny, do večerky nebo na trh. A teď si tam místo toho dosaďte CRM data, marketing data nebo finanční data.

Datová pipeline už je jen silnice mezi datovým skladem a datovým zdrojem, která se spouští v určitém intervalu. Zpracovává surové data a pošle je do skladu.

Pro ETL transformaci dat se nejčasteji používají nástroje typu SQL, Python script nebo no-code tooly, jako jsou Power Query v Excelu nebo Power BI. Znalost těchto nástrojů nám pomáhá automatizovat dopravu dat do požadované struktury. Chceme mít vybrané určité sloupečky a vyfiltrované řádky, s kterými dále budeme pracovat. A nechceme tyto věci opakovat dokolečka, když fungují spolehlivě díky ETL nástrojům.

3) Reporting

Jakmile máme ledničku naplněnou a kurýr nám pravidelně ledničku doplňuje, může se konat párty v podobě reportingu. Reporty jsou takovou odměnou pro datového analytika, který se ze skladu snaží vydolovat cenné informace pro business.

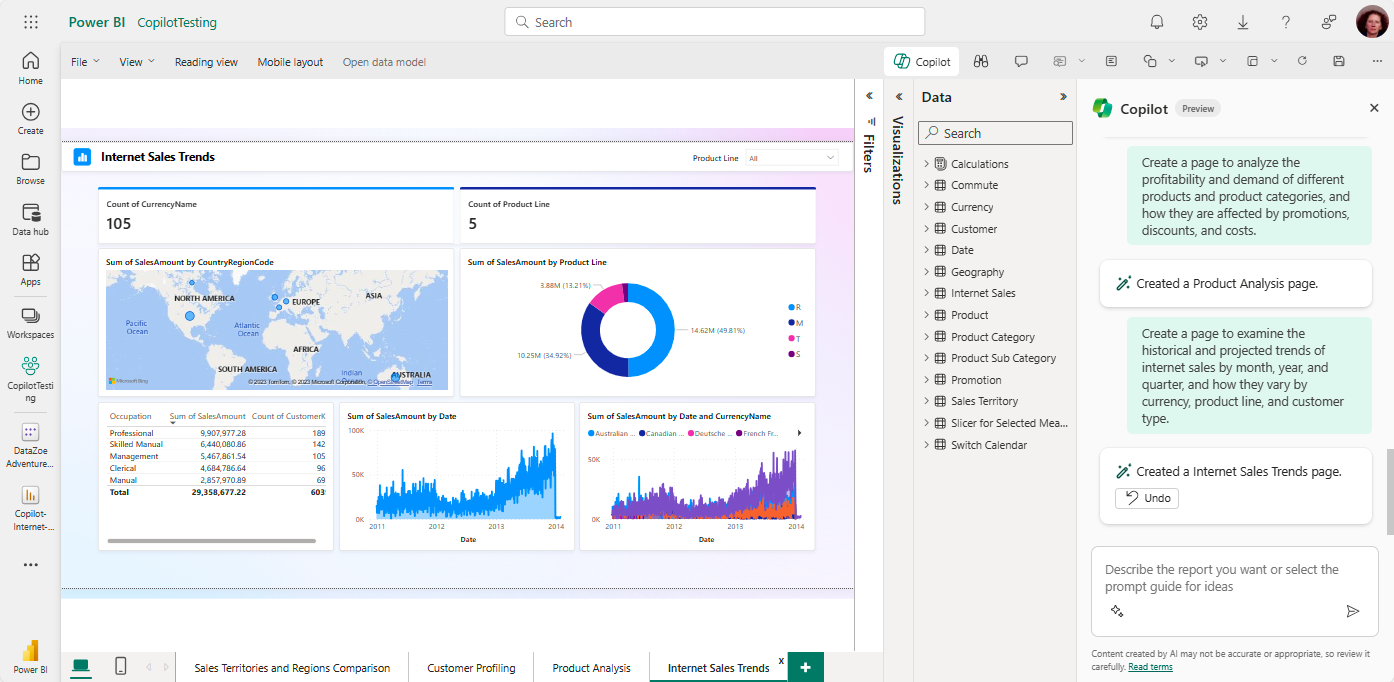

Nebo taky může zjístit, že bude muset vzít ruce do bahna a trochu se v databázi pohrabat. Nejznámějšími nástroji pro reporting jsou Power BI nebo Tableau. Existují i další nástroje pro určité datové zdroje, například Looker Studio pro Google Analytics 4, Google Ads a mnoho dalšího.

4) Data science slouží pro AI 🤖

Abychom dataři měli pořád práci a neváleli si šunky, poslední díl do skládačky patří artificial intelligence. Někdy zkrátka máme těch dat tolik, že nestačí udělat pár reportů a sledovat metriky.

Zajimavým příkladem je dešifrování řeči zvířat, kdy máme možnost na základě odhalených vzorců si s nimi konečně popovídat:)

Ale momentálně realističtějším příkladem je dát přístup AI ke všem datovým zdrojům, naučit ji na těchto datech pomocí machine learningu hledat vzorce a chrlit insights. Zní to jednoduše, ale k tomuhle stádiu je potřeba se dopracovat viz body výše. Nicméně vypadá to tak, že tomu jdou naproti i velké techy, jako je Microsoft a zavádí Copilota přímo do platformy. Čekají nás ještě zajímavé časy a datový analytik nebude mít za chvíli co žrát.

Pokud chceme ale zkoumat něco na malém písečku dat, nejznámějšími nástroji pro ADA (Advanced Data Analytics) za pomoci AI je chat.openai.com od OpenAI nebo claude.ai od Anthropic. Oba nástroje umožňují vkládat .csv files a dotazovat se na palčivé otázky typu jaké jsou prodeje za poslední rok nebo najdi mi, který obchodník roste YoY v sales.

Budoucnost dat je v rukou každého

Říká se, že s daty bude umět pracovat čím dál více lidí právě díky AI a no-code platformám. Pokud mě něco bude zajímat pro firemní prezentaci, půjdu se dotázat chatbota, ať mi najde odpověď. Nemusí to být jen jednorázovky. Prostě si vytvořím pomocí platformy automatizaci, abych nemusel data manuálně exportovat a upravovat stejným způsobem a opakovaně.